-

Normal eqation coursera 강의 정리머신러닝 2021. 10. 4. 22:54

앞에서는 선형회귀의 cost function을 통해 theta를 찾는 것에 대해 설명했다.

이번 강의에서는 gradient decent를 사용하지 않고 theta를 찾는 방법인 normal eqation에 대해 설명한다.

m개의 샘플과 n개의 feature가 있을때 m x (n+1)의 행렬로 나타낼수 있다.

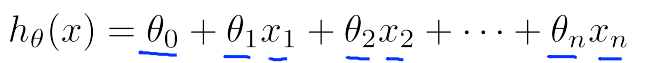

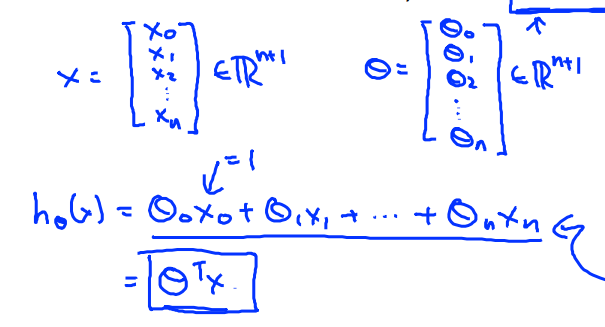

가설함수 h(x)는

같은 식으로 나타낼 수 있다. 이를 행렬식으로 나타낸다면 다음과 같다.

theta에 전치시킨 벡터에 X벡터를 곱한것으로 나타낼 수 있다.

이전에는 theta를 찾기 위해 비용함수를 미분하여 0이되는 theta를 찾았지만 역행렬을 이용한다면 쉽게 미분을 하지않고 쉽게 찾을 수 있다.

(X'X)의 역행렬만 구하면 theta를 바로 구할 수 있게 된다.

gradient decent방법과 normal equation의 방법에는 장단점이 있다.

gradient 학습률을 잘 설정해야하고 많은 반복을 필요로한다.

반면 noraml equation은 반복이 필요없고 학습률을 선택할 필요도 없다.

하지만 feature의 개수(n)가 커지면 상황은 달라진다.

역행렬을 구하는 작업은 복잡도가 n^3을 의미한다. 반면 gradient decent는 낮은 복잡도를 가지고있다.

상황에 따라 방법을 theta를 구하는 방법을 다르게 해서 적용을 할 수 있다.

'머신러닝' 카테고리의 다른 글

Logistic Regression 정리 (0) 2021.10.12 Logistic Regression [coursera 강의 정리] (0) 2021.10.05 Linear regressor (선형회귀) Coursera 강의 (0) 2021.09.27